Ces dernières semaines, ont été riches en rebondissements dans le domaine de l’intelligence artificielle (IA). A propos de la génération d’image, certains parlent de menace pour nos démocraties et d’armes de falsification massive.

Rappelons rapidement de quoi il s’agit. A partir d’un texte saisi sur une interface informatique utilisant l’IA, on peut produire en quelques secondes une image réaliste qui peut, dans certains cas, se révéler très trompeuse. Le passage à la version 5 de la solution Midjourney a fait faire un sérieux bond dans la qualité du rendu et, par là même, dans la capacité de tromperie de cette technologie.

Certes, des bévues graphiques persistent dans le rendu des mains et des textes, mais ne doutons pas que des ingénieurs de la Silicon Valley travaillent à résoudre le problème à plus ou moins court terme. N’oublions pas non plus, qu’à la différence de tout autre secteur industriel, le numérique double de puissance tous les 24 mois permettant ainsi à cette technologie gourmande en puissance de calcul de progresser très très vite.

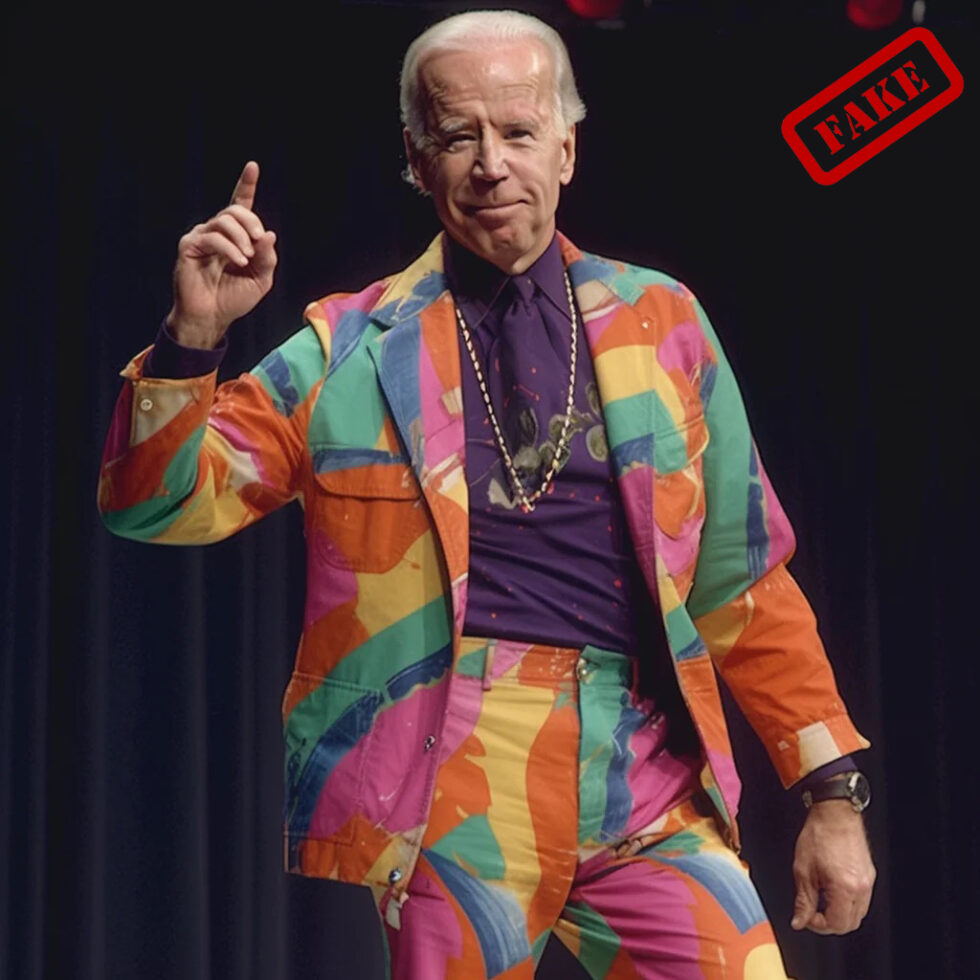

On a vu ainsi apparaître un pape en doudoune, le Président de la République française dans des manifestations ou assis sur des poubelles, Donald Trump en prison, etc. Cela pourrait simplement rester des blagues potaches et prêter à sourire mais l’affaire est nettement plus sérieuse. En effet, si il est possible dorénavant de produire en masse des images en apparence identiques à celles des photographies auxquelles nous sommes habitués, c’est la porte ouverte à toute les manipulations toxiques imaginables.

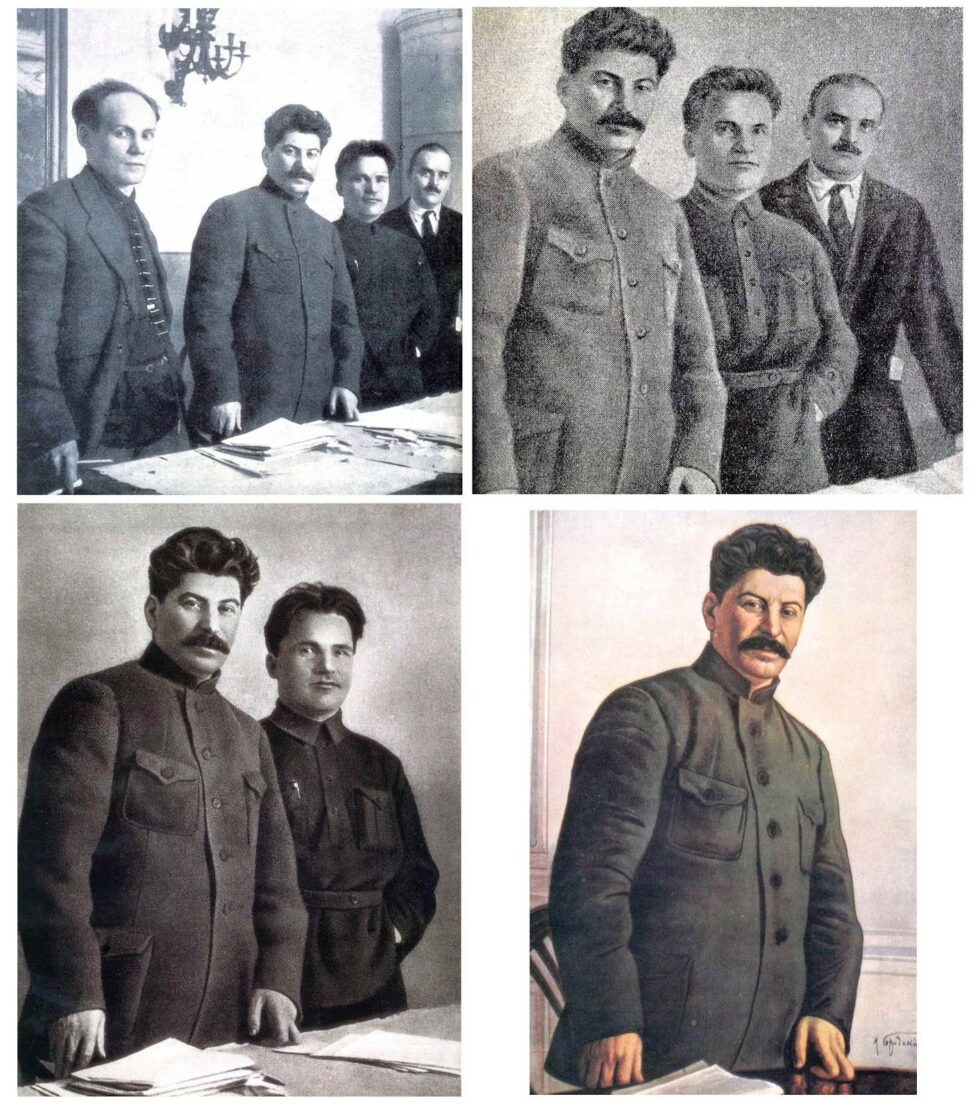

Les questionnements liés à l’utilisation détournée de la photographie ne datent pourtant pas d’aujourd’hui, loin s’en faut. Déjà, à l’aube du 20e siècle, les Soviétiques pratiquèrent une re-écriture des faits en faisant disparaître des compagnons de route de l’iconographie officielle au fur et à mesure des désamours du camarade Staline. Plus tard, dans une approche plus esthétique et moins sanglante, on éliminera des portraits, par exemple, la tache disgracieuse sur le crâne de Gorbatchev. La Chine de Mao pratiqua également l’effacement tant physique que photographique des gêneurs, sans oublier, à la fin du 19e siècle, la photo spirite de nos arrières grands-parents, truffée d’ectoplasmes et de fantômes d’ancêtres. Des artistes aussi pratiquèrent la manipulation dans un but plus noble comme John Heartfield et ses montages anti-nazis ou Joan Fontcuberta et ses images mêlant insolite et vraisemblable. Plus récemment, Jonas Bendiksen avait bien trompé son monde avec The book of Veles qui se voulait justement un avertissement sur les méthodes modernes de désinformation.

Mais revenons à aujourd’hui

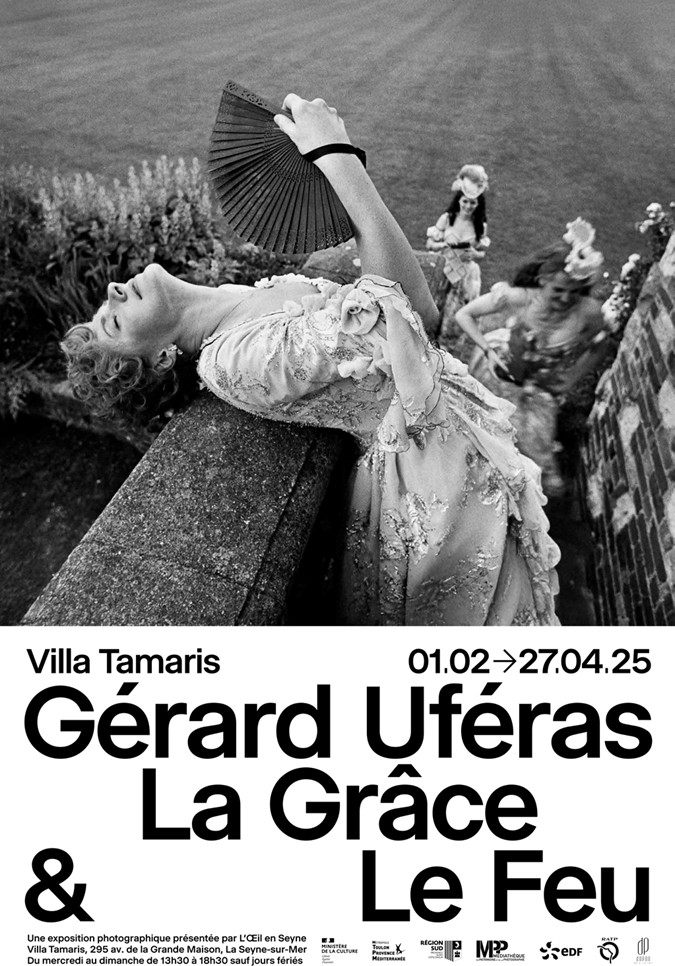

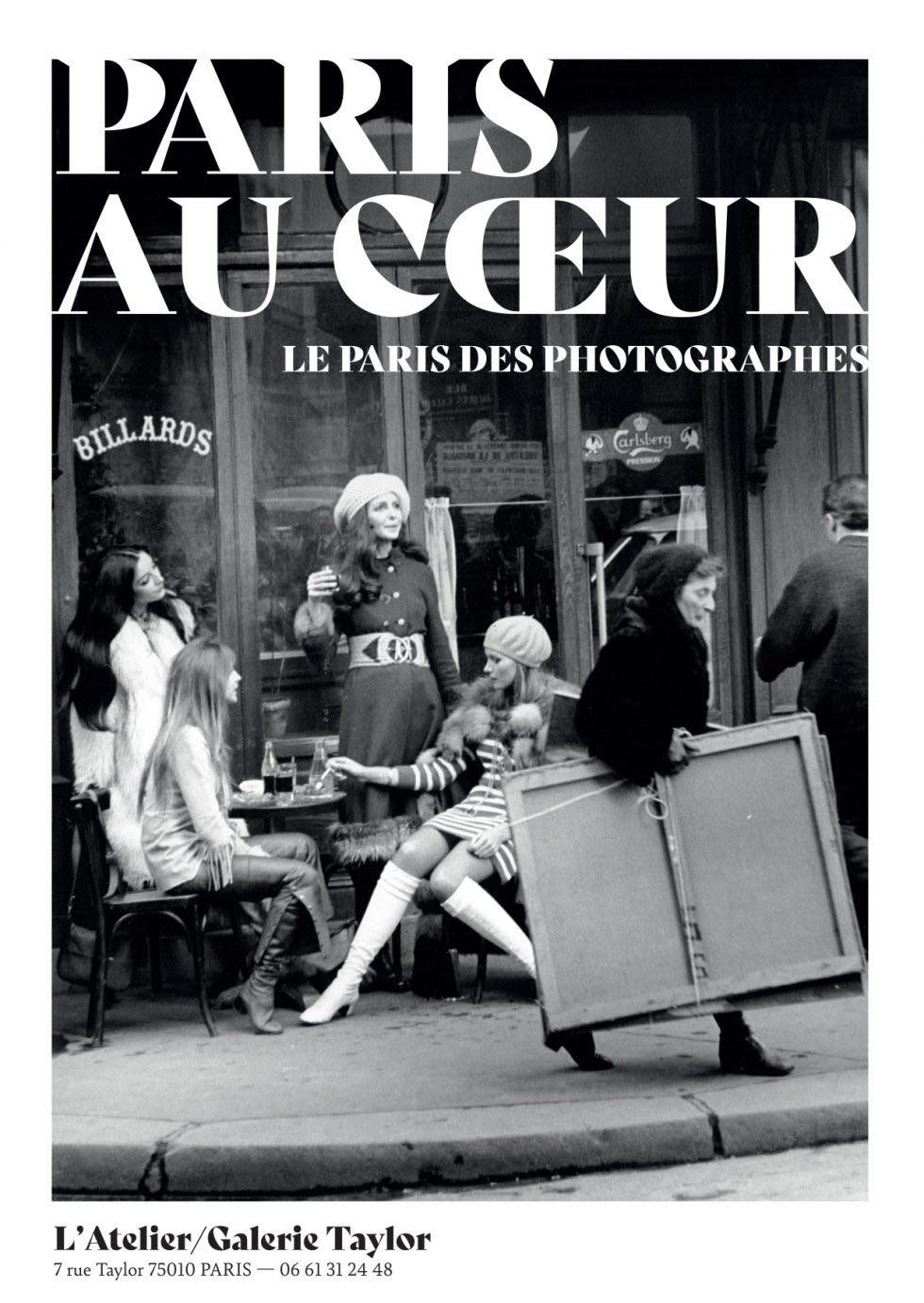

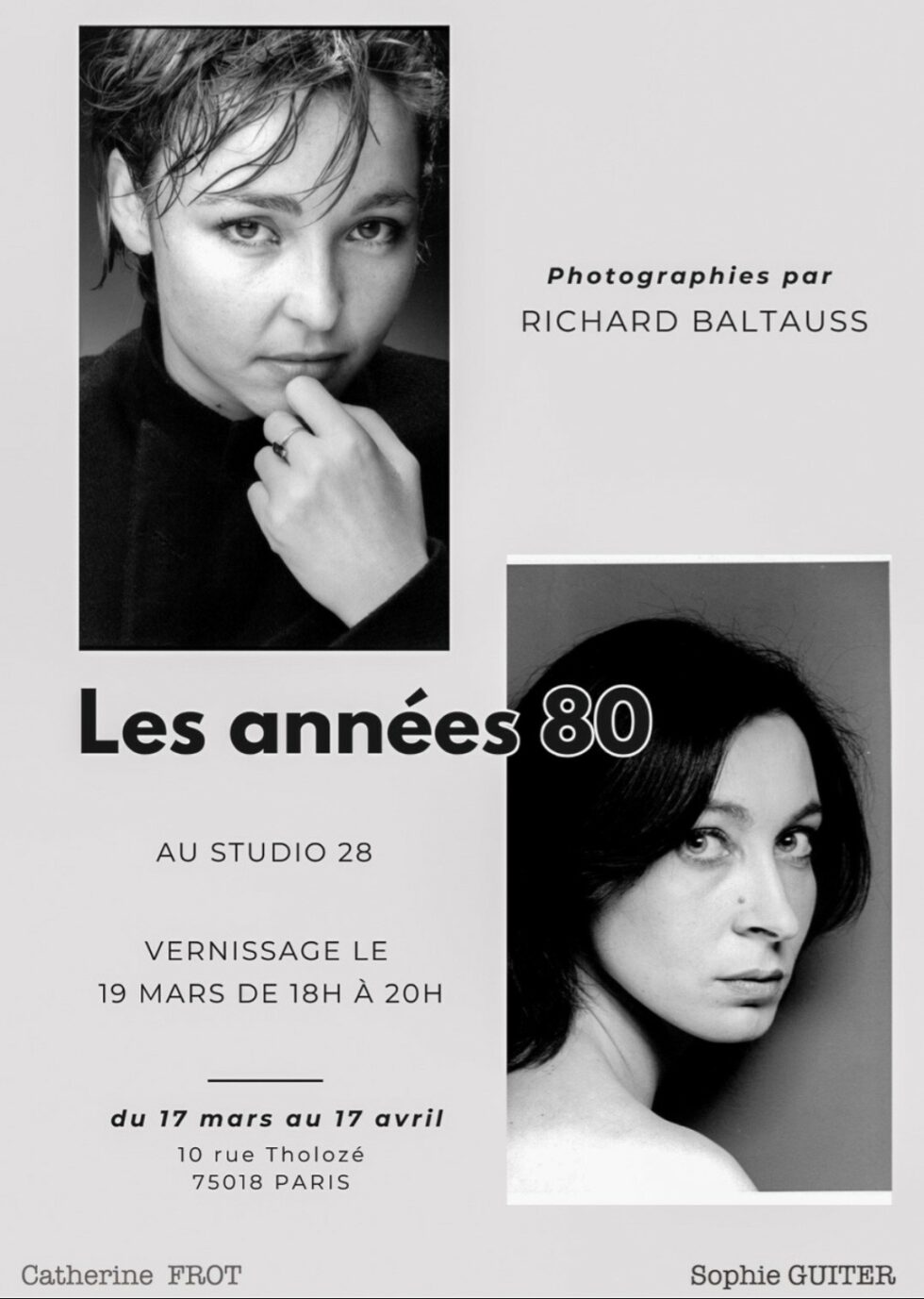

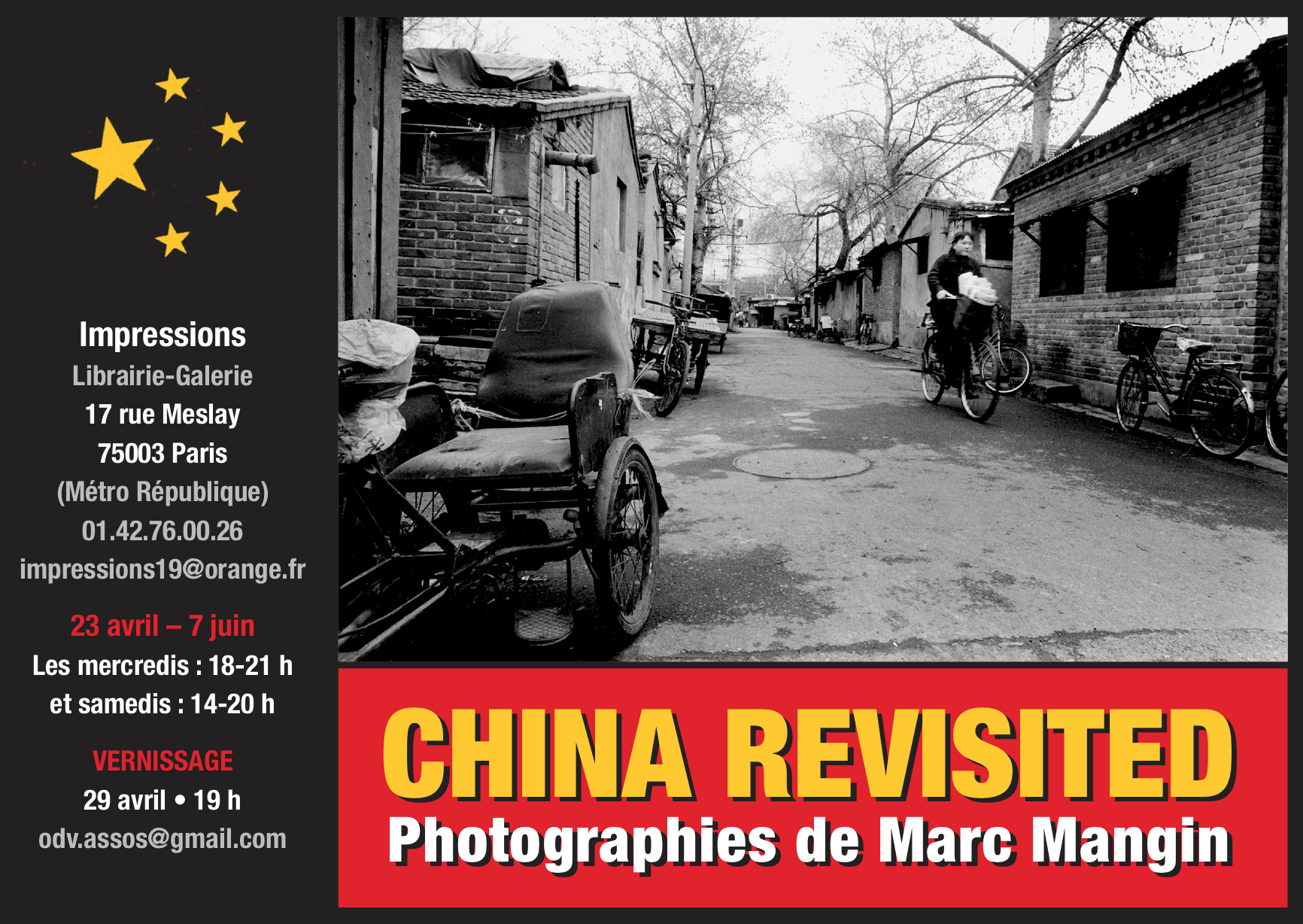

Toutes ces images ont été fabriquées par une IA

Au rythme où les choses bougent et où le réalisme des restitutions progresse à grands pas, on sera capable demain de fabriquer des images qui auront toutes les caractéristiques de la réalité et il sera bien difficile de faire le tri entre le vrai et le faux. A la différence de précédemment, l’outil est maintenant disponible pour tous, ne requiert que peu de compétence et la viralité de ces productions se fait à la vitesse de l’éclair, atteignant un vaste auditoire sans qu’il n’y ait validation ou médiation préalables.

Les réseaux sociaux, devenus aujourd’hui le seul canal d’information de centaines de millions de gens, restent et resteront le moyen privilégié de diffusion de fausses nouvelles et d’images manipulées. Et puis, pris dans l’accélération permanente de nos vies, qui s’attarde à ausculter chacune des images qui sont soumises à notre regard ? On voit beaucoup, on regarde peu et puis on croit ce que l’on veut croire comme le disait déjà Démosthène dans l’Antiquité.

Les complotistes, partisans de tous bord et autres censeurs peuvent se réjouir. On risque de voir apparaître un tsunami de « preuves par l’image » validant que la terre est plate, que l’expédition sur la Lune est une production hollywoodienne, que Joe Biden est un extra-terrestre venu asservir l’espèce humaine.

Autre sérieux souci, la falsification des archives historiques qui pourront être modifiées ou totalement inventées, créant une confusion qui pose le problème de notre rapport au passé et peut conduire à une grande défiance vis-à-vis de tout qui peut provenir de recherches historiques pourtant dignes de confiance. Et pourquoi pas des preuves visuelles « irréfutables » que les chambres à gaz n’ont jamais existé dans les camps de la mort ? Certains s’y sont déjà essayés sans trop de succès mais ils ne disposaient pas de la puissance de tromperie qu’aurait pu leur fournir la technologie. On peut s’en soucier sachant que le démenti d’une infox a un impact beaucoup moins important que la fausse nouvelle elle-même.

Autre problème et non des moindres. Si notre champ d’information est envahi de faux, il deviendra très facile pour certains de nier la véracité de photos ayant enregistré par exemple des violences policières ou des violations de droits de l’homme en clamant que ce ne sont que des images fabriquées par une IA. Dégât collatéral qui, après que l’on se soit demandé si une photo fausse était vraie, risque de nous voir nous demander si une photo vraie ne serait pas fausse finalement.

Depuis quelques temps, à l’initiative du Future of Life Institute, association américaine cherchant à diminuer les risques menaçant l’humanité, en particulier ceux de l’intelligence artificielle, circule une pétition demandant une pause de 6 mois dans la course en avant pour développer des IA de plus en plus performantes. Le texte se demande si il faut laisser les machines inonder nos canaux d’information de propagande et de mensonges.

Les médias, toujours avides de peopolisation, ont souligné que parmi les signataires figure Elon Musk. Notons qu’il a financé à son début OpenAI, société qui a développé les technologies qu’il critique maintenant. Comme son investissement initial a été bien dilué quand Microsoft a, à son tour, injecté des milliards de dollars dans l’affaire, on est en droit de se demander si il ne s’agit pas là d’une tentative pour rester dans le jeu. Et puis sur le plan défense contre les fake news, le patron de Twitter, libertarien et farouche opposant à toute forme de régulation, est peut-être assez mal placé pour donner des leçons. Mais que l’arbre ne cache pas la forêt, il y a là de quoi sérieusement réfléchir bien qu’on puisse douter de l’efficacité d’une telle mesure dans le sens où la bonne volonté seule n’arrêtera pas ceux qui voudront continuer à développer cette technologie, peut-être plus discrètement mais sûrement tout aussi efficacement.

Alors quelles pourraient être les pistes à suivre pour se prémunir contre les dérives de l’IA ? Tout d’abord, le plus largement possible, l’éducation aux médias, l’analyse critique des images et ce dès le plus jeune âge. Cela se fait déjà mais de manière encore trop timorée et nécessiterait une véritable volonté politique pour se doter des moyens suffisants pour y parvenir.

Autre possibilité, la piste technologique en développant des systèmes vertueux comme l’intelligence artificielle symbolique qui s’appuie sur un système de règles définies par les humains puis intégrées aux machines afin de guider de manière éthique leurs productions. Des recherches sont aussi menées pour intégrer un filigrane, imperceptible mais détectable avec les moyens appropriés, dans les images produites par une IA. Cela reste cependant une solution limitée qui ne protège pas complètement des tentatives d’effacement du marquage.

Et le juridique ? L’affaire est compliquée car le temps du juriste n’est pas le même que celui du citoyen. L’homme de loi prend, et c’est heureux, le temps de réfléchir et du pixel coulera sous les capteurs avant qu’une solution légale voit le jour. D’autant que les lois diffèrent selon les pays, droit d’auteur par ici, copyright par-là, alors que le numérique ne connaît pas de frontière.

Du côté des institutions qui régissent nos vies en société, notons que l’Union Européenne s’est emparée du sujet et planche sur une régulation des pratiques les plus risquées et souhaite favoriser l’innovation européenne en la matière.

Bref, développer et encadrer en privilégiant une approche par risques graduée allant de minimal à inacceptable, afin de favoriser les bénéfices sociaux et économiques tout en luttant contre ce qui pourrait porter atteinte aux droits fondamentaux des citoyens. Même si des initiatives vont déjà dans ce sens, il serait aussi bon d’augmenter la pression sur les plateformes de diffusion qui sont les principaux vecteurs de propagation des faux. Les considérer non plus comme de simples transmetteurs irresponsables mais comme des éditeurs à part entière soumis à des obligations et devant rendre des comptes sur les contenus qu’ils diffusent. On pourrait même envisager pour les producteurs de solutions basées sur l’IA, au vu du potentiel de dangerosité, une obligation à se soumettre à des certifications préalables avant mise sur le marché, comme c’est le cas pour les médicaments par exemple.

Enfin, une autre idée serait d’homologuer des producteurs et diffuseurs de « vraies » photographies ; leurs auteurs adhérerant à un code de bonne conduite en s’engageant à ne produire aucune image générée par IA sauf en le signalant clairement. Une sorte de contrat de confiance… Encore faudrait-il déterminer les conditions du fonctionnement d’un tel dispositif.

Éduquer, chercher des solutions techniques et règlementaires, labelliser peuvent apporter des solutions mais rien n’est joué et tout reste à faire. Alors conservons la maîtrise de notre sens critique qui reste, très certainement, une des plus belle manifestation de l’intelligence…humaine.

Gilles Courtinat

Voir également :

- La pétition du Future of Life Institute

- Le règlement européen sur les services numériques (Digital Service Act)

- Le Conseil national du numérique

Lire l’enquête de Gilles Courtinat faisant le tour de la question

Un nouvel outil pour la création? (3/7)

Et les photographes dans tout ça ? (4/7)

Banques d’images et questions de droits (5/7)

Prudence et opportunité pour la presse (6/7)

Qu’en pense l’IA ChatGPT ? (7/7)

Dernière révision le 9 octobre 2024 à 10:31 am GMT+0100 par

- Marc Riboud

Vietnam 1966-1976 - 28 mars 2025 - La Gacilly 2025

God save the planet - 28 mars 2025 - François Prost

Nids d’amour kitsch chez Agnès b. - 21 mars 2025

Et pour ne rien louper, abonnez vous à 'DREDI notre lettre du vendredi

Qui sommes nous ?

Qui sommes nous ?