Il y a presque 10 ans, André Gunthert, maître de conférences chargé de la chaire d’histoire visuelle à l’École des Hautes Etudes en Sciences Sociales (HESS), écrivait

« La transition numérique n’est pas la première rupture majeure qu’affronte le champs photographique, où l’évolution technique est une donnée familière. Mais elle est peut-être celle qui a le plus désarçonné les professionnels, tant ceux-ci ont multiplié les témoignages d’impréparation, d’incompréhension ou d’inadaptation. Désignant d’emblée comme post-photographique la forme numérique, nombre de spécialistes ont considéré l’ancien paradigme comme une citadelle assiégée, et le nouveau comme un envahisseur indésirable. » (L’image partagée, Editions Textuel 2015).

On pourrait reprendre aujourd’hui cette déclaration quasiment mot pour mot à propos de l’irruption massive de l’intelligence artificielle génératrice d’image. Nombreux sont ceux qui oscillent entre stupeur et déni, rares les autres qui ont décidé de se coltiner avec. Et si faire avec l’IA une image qui ressemble, peu ou prou, à une photo est finalement assez aisé, réussir à faire une œuvre fondée sur une véritable démarche créative n’est pas à la portée de tout un chacun. Utiliser l’outil va donner un résultat tout à fait différent selon la nature et la qualité de ce qu’on lui soumet comme texte. Et qui dit texte dit narration, contenu, récit, prose autant de termes qui nous renvoient à la littérature. Plutôt que de rester soumis à la machine, il s’agit d’engager une sorte de collaboration avec elle en créant « le récit d’un photographe qui parle littérature à une machine, laquelle lui répond en image. » S’ouvre alors la possibilité d’envisager les choses d’une manière complètement différente, la technologie redevenant ce qu’elle devrait toujours être, une assistance à la production de fictions au service de l’artiste.

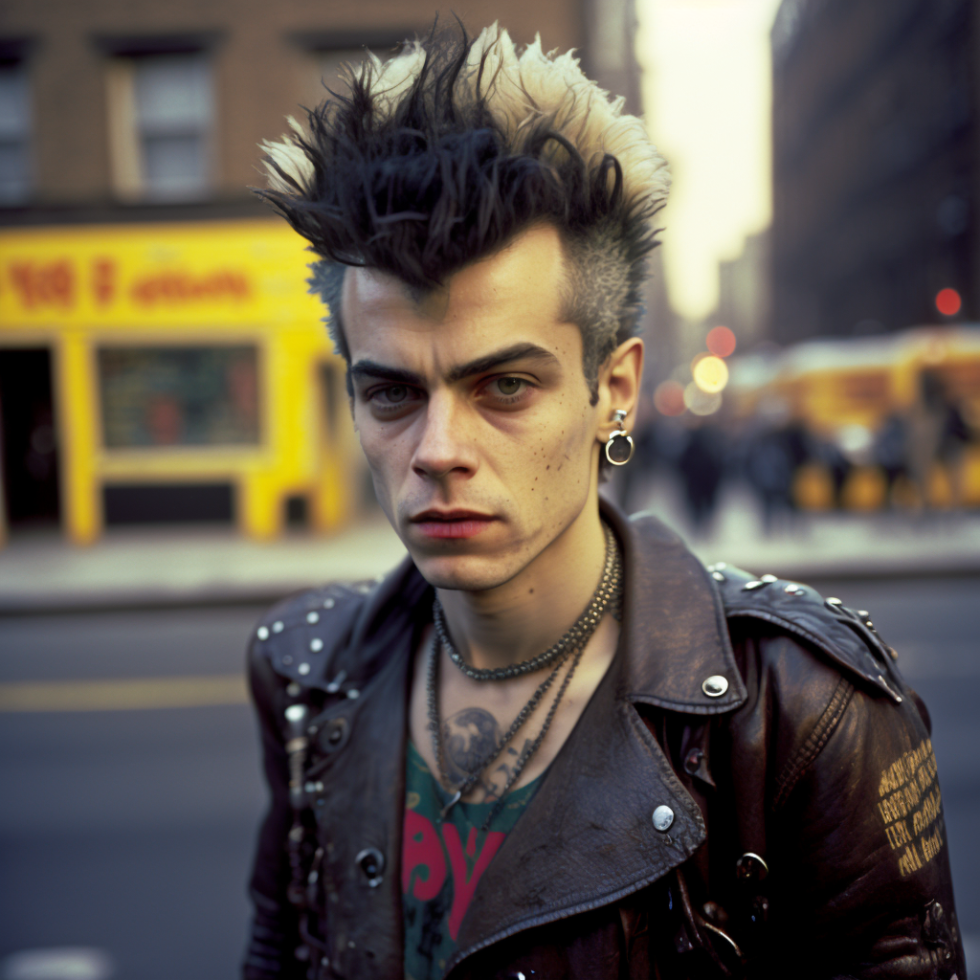

Partant de cette idée, Jean-Fabien Leclanche a entamé un projet, « New York outside my brain », qui est une déambulation imaginée dans le New York des années 70, ce qu’il n’a jamais pu faire et ne pourra jamais, mais qu’il a décidé de vivre malgré tout en l’inventant grâce à la technologie. Un livre de ce travail encore en cours sera publié aux Editions de Juillet fin 2023.

Ecouter la play list (bas de page) en regardant les photos et en lisant l’entretien

Entretien avec Jean-Fabien Leclanche

Qu’est-ce qui t’as amené à utiliser l’intelligence artificielle dans ton travail ?

La curiosité en voyant l’arrivée d’une technologie mise à la disposition du grand public, ce qui est très important à prendre en considération parce que ça va avoir des conséquences qui sont absolument majeures, y compris pour les acteurs professionnels du secteur. Le fait que cette technologie soit ouverte, accessible et manipulable par des non spécialistes, des non professionnels avec des résultats probants, fait partie de l’équation. Je me suis dit que si un gamin de 10 ans pouvait manipuler MidJourney, moi qui utilise la photographie et le texte, parce que j’aime aussi les mots, pourquoi je n’irais pas voir comment ça fonctionne ? Ce qui m’a frappé, c’est la facilité d’accessibilité et de maîtrise à la portée de tous, qui supprime la notion d’acquis, c’est sans doute pour ça que de nombreux professionnels en ont peur. Ces images ont tout à coup inondé les réseaux, pas en quelques années, en quelques semaines. Il y a eu une espèce de tsunami d’images toutes plus délirantes les unes que les autres a déferlé, avec un champ des possibles absolument infini.

Pour ton projet tu dis qu’il s’agit d’un photographe qui parle littérature à une machine laquelle lui répond avec des images. Expliques nous.

C’est aussi simple que ça, sachant qu’il faut avoir la maîtrise des mots absolument nécessaire pour arriver à un résultat de qualité. Il faut bien sûr travailler par itération, mais c’est le propre de l’IA générative. Etre capable de faire un choix et connaître un peu la partie technique, avoir les bons réglages pour pouvoir qualifier précisément l’image que tu veux obtenir. Comme photographe, tu dois avoir une connaissance qu’un nouveau venu n’aura pas, parler ouverture, vitesse, diaphragme, pellicule, lumière, profondeur de champs, etc.

Ça nous amène à la culture, l’expérience, l’acquis qui ferait la différence?

Oui et non. Tu t’aperçois que tu peux très bien y arriver sans rien y connaître. Tu peux faire une image très qualitative en demandant un rendu Leica M6 fait avec un Summilux 35mm f/2, avec l’aspect d’une pellicule Kodachrome 2, parce que tu sais que ça a été produit entre 1972 et 1973. Donc, dans ta tête, tu sais déjà quel sera le rendu que tu veux. Et puis, tu peux avoir le copain d’à côté qui va te faire un prompt beaucoup plus approximatif en collant dedans des tas de mots comme Nikon, Kodak, Leica, etc. et qui aura un rendu photographique tout aussi accompli au final. Donc, c’est pas si vrai cette histoire d’acquis et c’est ça qui est inquiétant. Par contre, si tu sais raconter ton histoire en tant que photographe, c’est que tu sais énoncer l’orientation de ta prise de vue. Tu sais où tu es dans l’espace, si tu veux une plongée, une contre-plongée, tu vas parler de la lumière, de la saison, de l’heure en sachant que ça va avoir un impact sur l’image. Ça, c’est effectivement une connaissance faite de réflexion et de pratique que n’aura pas un novice qui va penser pop culture, avec des références de dessins animés, de séries Netflix, etc.

Ce qui me plaît le plus dans la pratique de l’intelligence artificielle générative, ce sont ces espèces d’haïkus que sont les prompts, qui exigent à la fois une forme de poésie et de la rigueur dans la façon dont tu vas articuler ton propos et ce que tu vas raconter comme histoire. Ce sont des exercices de narration articulés avec des éléments techniques qui vont aboutir à une image. Une espèce de petit exercice littéraire permanent qui t’oblige à avoir ton image à l’esprit et à devoir la restituer très précisément en mots. C’est ce rapport à la machine et à l’algorithme qui est intéressant, parce qu’ensuite, tu vois de quelle manière c’est compris et de quelle manière c’est interprété.

Il y a donc une sorte de circulation en boucle entre l’image que tu as en tête qui va se transformer en mots, qui eux-mêmes vont se retransformer en une image ?

On sait que ces technologies peuvent faire tout et n’importe quoi, surtout n’importe quoi. Tout l’intérêt, c’est d’arriver à contraindre la technique à faire ce que tu souhaites qu’elle fasse pour toi, qu’elle se rapproche de ton modèle mental quand tu te mets derrière le clavier avec une certaine idée et que tu essaies de dialoguer avec la machine en la contraignant à comprendre ce que tu as à l’esprit pour que le rendu en soit le plus proche possible.

Mais ce qui est aussi intéressant, c’est que malgré tout, elle est capable de te surprendre. C’est à dire de te faire un résultat qui va être correctement contextualisé par rapport à ce que tu as demandé, mais parfois avec quelque chose en plus auquel tu n’aurais même pas rêvé. Une touche de poésie, un truc complètement inepte ou au contraire, une qualité de lumière, quelque chose qui te fait dire « Mince, c’est beau quand même ! »

Alors, la rigueur qu’il faut avoir pour trouver les mots justes et la bonne articulation du récit s’accommode d’une part de hasard ?

Je ne sais pas si on peut parler de hasard ou alors de hasard créatif parce que c’est quand même aléatoire. Tu ne pourras jamais avoir l’image que tu veux puisque ce n’est pas toi qui la produit. Tu la dictes, tu la racontes, tu la commandes et tu espères que le résultat va être au plus près de ton envie, de ton espoir, de ton attente, de ton délire. Mais en vérité, il y aura toujours un petit gap qui fait que la machine t’obéira au mieux, mais jamais vraiment totalement. D’ailleurs, une technologie qui serait capable de produire parfaitement ce que j’attends d’elle, est-ce si intéressant ? Si c’était le cas, ça deviendrait un outil de production lambda. Là, ce qui m’intéresse, c’est que je sais qu’à un moment, la machine va me proposer d’aller quelque part avec elle. J’initie le voyage, mais c’est elle qui en cours de retour modifie un peu la destination. Et le point d’arrivée, c’est dire « OK, on est d’accord tous les deux. »

Il s’agit donc d’articuler contrainte et collaboration avec la machine ?

Tout à fait. Il faut absolument la contraindre, ne pas la lâcher, sinon elle t’amènera nulle part. C’est dangereux parce que c’est extrêmement addictif et tu peux te retrouver pendant des heures à pondre du prompt, tout ce qui te passe par la tête, et c’est extrêmement épuisant mentalement. Tu es comme un hamster dans sa roue, mais au final, tu ne produis rien, juste du contenu. C’est pour ça qu’il faut contraindre, mais aussi se contraindre soi même. Je fais la différence entre ce qui est contenu et ce qui est produit créatif, art, production artistique, etc. Ce n’est pas la même chose bien que réalisé avec le même outil.

Mais ce qui est, par contre, assez dangereux, c’est que cette technologie vient s’introduire dans trois domaines qui, jusqu’à présent, étaient ceux qui pouvaient définir la notion d’art. En gros, ce sont l’inné et l’acquis, la temporalité et la transgression.

On a affaire à une technologie qui peut permettre à des gens, qui n’étaient pas des artistes, d’avoir aujourd’hui la possibilité de jouer sur la transgression, de jouer sur la temporalité et de se départir de la notion d’inné et d’acquis. Ces trois armes mises entre les mains de tout un chacun, viennent énormément déstabiliser les notions de propos et d’œuvres artistiques ou d’auteur.

Et puis, je vois beaucoup parler des craintes concernant la production de fake news et de fausses images, ce que je ne remets pas du tout en question. Mais je suis étonné qu’on ne parle pas de l’IA comme d’une arme de guérilla citoyenne, en dehors des gouvernements, des propagandistes professionnels, des gens qui font des œuvres de déstabilisation, ce qui risque effectivement d’être un très gros problème. Un outil pour des gens qui ne vont pas agir avec une conscience politique, mais qui vont avoir entre leurs mains la possibilité d’exprimer de manière spontanée un certain nombre de choses, d’interpréter leurs colères, leur vision du monde, de pousser leurs fantasmes. Si un jour certains veulent, par exemple, décapiter le Président de la République avec l’IA générative d’image ils pourront le faire. Ce sera vrai pour tous les domaines, politique, culture, etc. Je pense que ça remet beaucoup en question la parole artistique, en permettant la transgression de manière immédiate, sans aucun acquis nécessaire, en redistribuant les cartes et c’est pour ça que ça pose problème.

Comment s’est élaboré le projet ?

Quand j’ai commencé à jouer avec l’IA, assez rapidement, j’ai eu un réflexe de photographe qui a été celui qui avait contribué à la production de mes deux premiers bouquins, basés sur l’idée que le volume fait sens. Je suis plutôt spécialisé dans le récit de territoire au sens large, les lieux de vie. Pour que ce genre de récit existe dans sa cohérence, il faut aussi que le sens soit apporté par le volume, donc travailler sur la série.

J’ai voulu prendre le contrepied de ce qu’à l’époque tout le monde faisait avec l’IA, c’est-à-dire de l’image futuriste, des contextes qui ne pouvaient pas exister. Beaucoup de steampunk, de science-fiction, de mises en scène surréalistes. J’ai voulu utiliser la fiction en faisant appel, non pas à l’avenir, mais au passé, me projeter dans quelque chose que je n’avais pas vécu. Je me suis demandé ce que j’aurais adoré vivre. J’ai toujours aimé le New York de la fin des années 70 et du début des années 80, parce que j’aime les villes et la culture à cette époque là. J’ai décidé de faire un voyage de 15 jours à New York entre 1975 et 1982 et de vivre des moments qui ne me seront jamais donnés de vivre dans la vie réelle. Donc, je me suis servi de l’IA comme à un moteur de production fictionnelle et non pas simplement comme un moteur de production image par image.

Je suis allé dans les boites, dans le New York gay, bien sûr au CBGB voir un concert des Ramones. J’ai vu les flics, les émeutes, le début du féminisme, Manhattan en chantier. J’ai déambulé dans les rues. Je n’ai pas, pour autant, laissé l’IA me raconter n’importe quoi ou me produire n’importe quoi, je savais à quoi ressemblait la ville à l’époque. C’est un entre-deux avec des racines historiques fortes, un New York qui n’existe pas mais que tout le monde peut reconnaître.

Le texte, tu l’écris classiquement ou tu fais aussi appel à l’IA ?

Je me suis posé la question mais je me suis dit qu’il fallait penser aux lecteurs. Proposer un voyage en images à New York dans les années 70 réalisé avec l’IA, c’est un discours cohérent, que tu peux expliquer et défendre, c’est recevable. Mais faire écrire le texte par ChatGPT et mettre mon nom dessus, ça me dérange. Et d’ailleurs, travailler à partir de ces images d’IA pour penser un texte, c’est vraiment intéressant.

Pour l’instant c’est encore en chantier et je laisserai volontairement quelques images avec des aberrations graphiques car, cette dimension clairement imparfaite de l’IA m’intéresse dans son potentiel poétique et surréel. Je pense que la version finale ne comportera pas uniquement des reproductions sans aspérité. Par exemple faire un portrait d’un gang latino où il y a un mec qui a six doigts, ça me plait. Je trouve les faiblesses, la fragilité, l’imperfection de l’IA séduisantes du point de vue créatif, ça rend la chose absolument impossible, malgré une certaine forme de vraisemblance.

Et ton sentiment sur le développement de la technologie générative d’image ?

Il y a plusieurs pans de la pratique photographique qui sont effectivement en péril et ne survivront pas. Cela dit, on aura toujours besoin du regard des photographes sur le monde, l’environnement, l’actualité de la planète. L’IA peut elle se substituer à la couverture de la guerre en Ukraine? Surement pas. Peut elle brouiller la compréhension et la lecture du conflit en produisant des fake images? Oui, mais il y aura toujours des photographes pour raconter des histoires, pour regarder autour d’eux. Et ça, je crois que ça restera pérenne, même si c’est juste un segment de la photographie.

Et puis, il faut s’intéresser aux auteurs mais aussi aux récepteurs, parce que l’enjeu se place sur ce public devenu à la fois producteur, diffuseur et récepteur. Ça va aussi beaucoup dépendre des canaux. C’est-à-dire qu’est-ce que seront les réseaux sociaux dans dix ans? Quels seront les terminaux? Et je ne sais pas si énergétiquement parlant, on va pouvoir avoir les moyens de longtemps continuer comme maintenant. On est dans un monde fini, on épuise les ressources, on dérègle le climat. On fait comme si dans 15 ans, tout ça n’aurait toujours aucune importance, qu’on pourrait encore recharger nos smartphones comme on veut, qu’on aurait des tas de terminaux sur nous, que l’IA résoudrait plein de choses. OK, sauf que, si à un moment donné, on ne peut plus alimenter les data centers, ni recharger notre smartphone, ni payer la facture d’électricité, on sera bien obligé de revenir à de la low-tech. Je ne sais pas si on n’est pas en train de vivre une sorte de dernier hoquet de l’humanité post-moderne qui aurait touché Dieu du doigt, mais va revenir fissa à l’âge de pierre parce que sinon, on va tous crever.

Propos recueillis par Gilles Courtinat

La playlist:

Dernière révision le 29 octobre 2024 à 12:17 pm GMT+0100 par

- Alan Adler

L’homme le plus photographié d’Australie - 11 avril 2025 - Vidéosurveillance algorithmique

Le doigt dans l’engrenage sécuritaire ? - 4 avril 2025 - Marc Riboud

Vietnam 1966-1976 - 28 mars 2025

Et pour ne rien louper, abonnez vous à 'DREDI notre lettre du vendredi

Qui sommes nous ?

Qui sommes nous ?